El siguiente artículo fue escrito en 2017 por el periodista científico Mark Lorch y publicado en The Conversation . El original en inglés puede encontrarse aquí.

Por qué la gente cree en las teorías de la conspiración y cómo hacerles cambiar de opinión

Estoy sentado en un tren cuando un grupo de aficionados al fútbol entra en tropel. Recién salidos de un partido –su equipo ha ganado claramente– ocupan los asientos vacíos a mi alrededor. Uno recoge un periódico abandonado y se ríe con desdén mientras lee los últimos "hechos alternativos" difundidos por Donald Trump.

Los demás pronto aportan sus opiniones sobre la afición del presidente estadounidense por las teorías conspirativas. La charla rápidamente deriva hacia otras conspiraciones y disfruto escuchando a escondidas mientras el grupo ridiculiza ferozmente a los terraplanistas, los memes sobre estelas químicas (chemtrails) y la última idea de Gwyneth Paltrow.

Luego se produce una pausa en la conversación, y alguien aprovecha para intervenir con: "¡Esas cosas quizá sean tonterías, pero no intentes decirme que puedes confiar en todo lo que nos dice el sistema! Mira los alunizajes, obviamente fueron falsificados y ni siquiera lo hicieron bien. ¡El otro día leí un blog que señalaba que ni siquiera hay estrellas en ninguna de las fotos!".

Para mi asombro, el grupo aporta otras "pruebas" que apoyan el fraude del alunizaje: sombras inconsistentes en las fotografías, una bandera ondeando cuando no hay atmósfera en la luna y cómo Neil Armstrong fue filmado caminando sobre la superficie cuando no había nadie para sostener la cámara.

Hace apenas un minuto parecían personas racionales, capaces de analizar evidencia y llegar a conclusiones lógicas. Pero ahora la situación está derivando hacia el absurdo. Así que respiro profundamente y decido intervenir.

"En realidad todo eso puede explicarse bastante fácilmente…"

Se vuelven hacia mí horrorizados de que un extraño se atreva a entrometerse en su conversación.

Continúo impertérrito, asestándoles una ráfaga de hechos y explicaciones racionales.

"¡La bandera no ondeó al viento, solo se movió cuando Buzz Aldrin la plantó!

Las fotos se tomaron durante el día lunar – y obviamente no puedes ver las estrellas de día.

Las sombras extrañas se deben a los objetivos de gran angular que usaron, que distorsionan las fotos.

Y ... nadie grabó a Neil bajando la escalerilla. Había una cámara montada en el exterior del módulo lunar que lo filmó dando su gran salto.

Si eso no basta, la prueba definitiva final proviene de las fotos tomadas por la sonda espacial Lunar Reconnaissance Orbiter de los lugares de alunizaje, en las que se pueden ver claramente las huellas que dejaron los astronautas al caminar sobre la superficie lunar".

"¡Asunto arreglado!", pienso para mí.

Sin embargo, parece que mis oyentes están lejos de estar convencidos. Se vuelven contra mí, esgrimiendo afirmaciones cada vez más ridículas. Aseguran que Stanley Kubrick filmó todo, que personas clave han muerto de formas misteriosas, y así sucesivamente.

El tren llega a una estación que no es la mía, pero decido bajarme igualmente para reflexionar sobre lo ocurrido. Expuse varios hechos claros y respaldados con evidencia, pero no lograron cambiar su opinión ni siquiera un poco. Me quedé pensando: ¿por qué, a pesar de los argumentos sólidos, no tuve ningún efecto en ellos?

La respuesta sencilla es que los hechos y los argumentos racionales no siempre son suficientes para modificar las creencias de las personas. Esto se debe a que el cerebro, aunque racional en apariencia, está moldeado por un diseño evolutivo que no siempre favorece la lógica por encima de todo. Una de las razones por las que surgen tan frecuentemente las teorías conspirativas es nuestra tendencia natural a imponer orden al caos y a detectar patrones incluso donde no los hay. De hecho, un estudio reciente encontró una correlación entre el deseo individual de estructura y el grado de susceptibilidad a creer en teorías conspirativas.

Tomemos esta secuencia como ejemplo:

0 0 1 1 0 0 1 0 0 1 0 0 1 1

¿Ves un patrón? Es muy probable que sí — y no eres el único. Una encuesta rápida en Twitter, inspirada en un estudio más riguroso, mostró que el 56% de las personas también lo percibieron. El problema es que la secuencia fue creada completamente al azar, lanzando una moneda.

Nuestra necesidad de encontrar orden y nuestra habilidad para detectar patrones pueden llevarnos demasiado lejos. A veces vemos conexiones donde no las hay. Es algo común: como cuando identificamos formas en las nubes, creemos ver figuras en el cielo, o pensamos que las vacunas causan autismo, a pesar de que esa idea carece de fundamento científico.

La capacidad de reconocer patrones fue probablemente una ventaja evolutiva para nuestros ancestros: era mejor equivocarse al detectar la presencia de un depredador que ignorar la señal de un gran felino hambriento. Sin embargo, en nuestro mundo actual, lleno de información y estímulos constantes, esa misma tendencia nos lleva a ver conexiones donde no las hay — como causas y efectos falsos o teorías conspirativas — por todas partes.

Presión social

Una de las razones por las que tendemos a creer en teorías conspirativas es que somos animales sociales. A lo largo de nuestra evolución, mantener una buena posición dentro del grupo ha sido más importante para la supervivencia que tener siempre la razón. Por eso, constantemente comparamos nuestras ideas y comportamientos con los de nuestro entorno y ajustamos nuestros puntos de vista para encajar. Esto significa que si quienes nos rodean creen en algo, lo más probable es que terminemos creyéndolo también nosotros.

Este fenómeno fue demostrado claramente en 1961 por el psicólogo social Stanley Milgram — conocido sobre todo por sus experimentos sobre obediencia a la autoridad — en un experimento sencillo y curioso: el “experimento de la esquina”. Consistía en colocar a una persona mirando hacia el cielo en una calle concurrida. Solo con eso, alrededor del 4% de los transeúntes se detenían a imitarla. Pero cuando el número de personas mirando al cielo aumentaba hasta quince, cerca del 40% de los transeúntes hacían lo mismo. Seguramente has vivido algo similar: en un mercado, por ejemplo, tiendes a acercarte a un puesto que tiene muchas personas observándolo.

Este efecto se extiende también a las ideas. Cuantas más personas creen en una afirmación, más fácil nos resulta aceptarla como verdadera. Si estamos expuestos repetidamente a una idea dentro de nuestro círculo social, esta acaba formando parte de nuestra visión del mundo. En otras palabras, la prueba social —es decir, ver que muchos otros creen algo— suele ser más persuasiva que la evidencia real. De hecho, este principio es tan poderoso que se usa ampliamente en publicidad: frases como "el 80% de las mamás está de acuerdo" no buscan informar, sino influir.

Pero la prueba social es solo una de varias formas en que ignoramos la evidencia a través de falacias lógicas . Otra es el sesgo de confirmación, una tendencia muy común que hace que busquemos y demos crédito a la información que respalda nuestras creencias, mientras rechazamos o ignoramos la que las contradice. Todos somos susceptibles a él. Piensa, por ejemplo, en la última vez que escuchaste un debate político en radio o televisión: ¿qué tanto peso le diste a los argumentos contrarios a los tuyos comparado con los que apoyaban tu postura?

Probablemente, sin importar lo razonables que fueran ambas posiciones, descartaste rápidamente las opiniones opuestas y te sentiste inclinado a aceptar las que coincidían contigo. Este sesgo también se manifiesta en la forma en que elegimos nuestras fuentes de información: solemos preferir aquellas que ya refuerzan nuestras ideas. Y esto explica, en gran parte, por qué tus creencias políticas suelen determinar qué medios de noticias consumes.

La diferencia

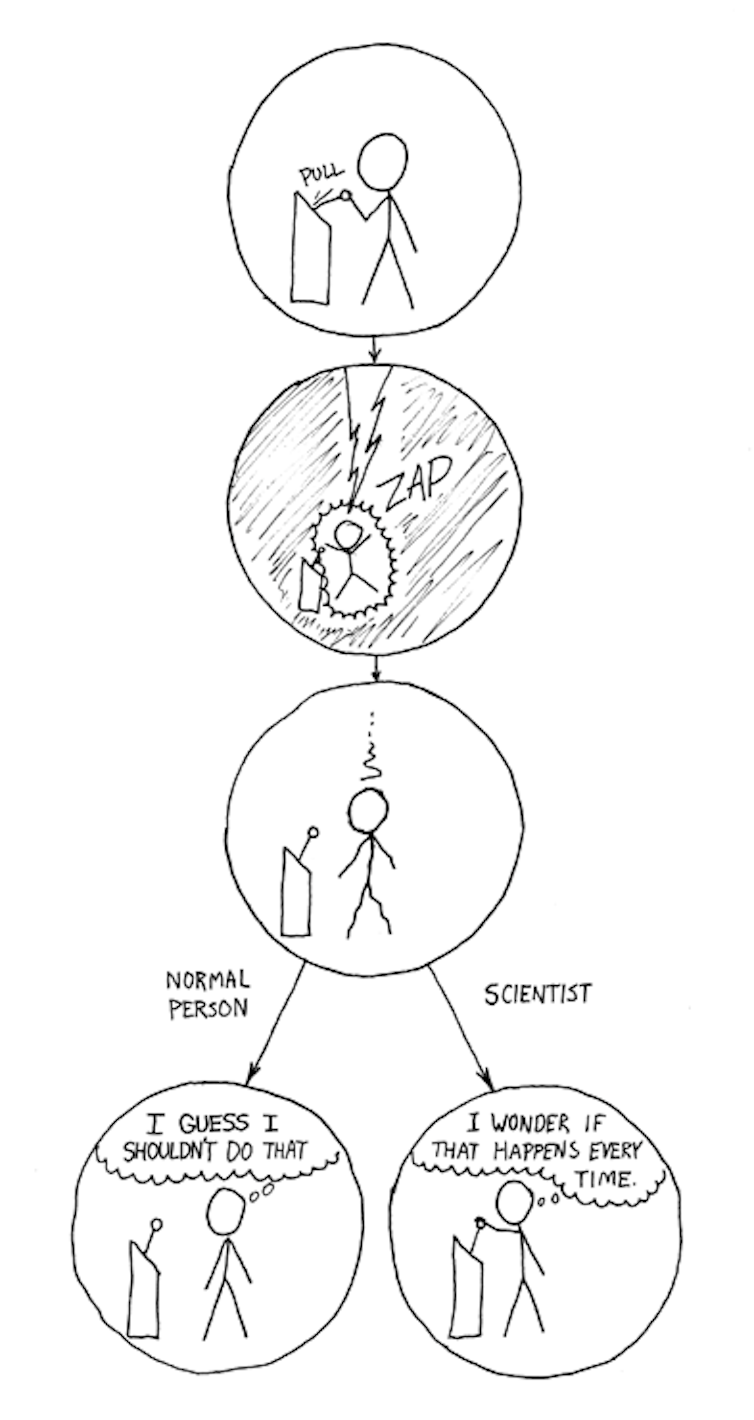

Por supuesto, existe un sistema de creencias diseñado específicamente para reconocer y reducir falacias lógicas como el sesgo de confirmación: la ciencia. A través de la repetición de observaciones y experimentos, la ciencia transforma anécdotas en datos confiables, minimiza los sesgos y permite que las teorías se actualicen cuando aparece nueva evidencia. Esto significa que, a diferencia de otras formas de conocimiento, la ciencia está abierta a revisar y corregir sus propias conclusiones.

Sin embargo, eso no nos inmuniza contra el sesgo de confirmación. Ni siquiera a los científicos. El famoso físico Richard Feynman contó una vez un ejemplo de este sesgo dentro de una de las áreas más rigurosas de la ciencia: la física de partículas. Un campo donde se espera precisión extrema, pero donde incluso los expertos pueden verse influenciados por sus propias expectativas.

"Millikan midió la carga de un electrón mediante un experimento con gotas de aceite en caída y obtuvo un resultado que ahora sabemos no es del todo correcto. Es un poco inexacto, porque usó un valor incorrecto para la viscosidad del aire. Es interesante observar la historia de las mediciones de la carga del electrón después de Millikan. Si las graficas como función del tiempo, encuentras que una es un poco mayor que la de Millikan, y la siguiente es un poco mayor que esa, y la siguiente un poco mayor que esa, hasta que finalmente se estabilizan en un número más alto."

"¿Por qué no descubrieron de inmediato que el nuevo número era mayor? Es algo de lo que los científicos se avergüenzan – esta historia – porque es evidente que la gente hizo cosas como esta: Cuando obtenían un número demasiado por encima del de Millikan, pensaban que algo debía estar mal y buscaban y encontraban una razón por la que algo podría estar mal. Cuando obtenían un número más cercano al valor de Millikan, no buscaban con tanto ahínco."

Errores de desmitificación

Es posible que te sientas tentado a seguir el ejemplo de los medios populares y tratar las ideas erróneas y teorías conspirativas con el enfoque de desmitificación. Presentar el mito junto con la realidad parece una buena forma de confrontar los hechos con las falsedades cara a cara, para que la verdad quede en evidencia. Pero nuevamente, este enfoque resulta ser contraproducente: parece generar lo que se conoce como el efecto contraproducente, "backfire effect" en inglés, un fenómeno en el cual el mito termina siendo más recordado que el hecho real.

Uno de los ejemplos más llamativos de esto se vio en un estudio que evaluaba un folleto titulado"Mitos y hechos" sobre vacunas contra la gripe. Inmediatamente después de leer el folleto, los participantes recordaban con precisión los hechos como hechos y los mitos como mitos. Pero apenas 30 minutos después esto se había invertido completamente, siendo mucho más probable que los mitos fueran recordados como "hechos".

Simplemente, el mencionar los mitos en realidad ayuda a reforzarlos. Y luego, a medida que pasa el tiempo, olvidas el contexto en que escuchaste el mito –en este caso durante un desenmascaramiento– y solo queda el recuerdo del mito en sí.

Para empeorar las cosas, presentar información correctiva a un grupo con creencias firmes puede en realidad terminar fortaleciendo su opinión previa,incluso cuando la nueva información la contradice. La nueva evidencia genera inconsistencias en nuestras creencias y solemos recurrir a la autojustificación y desarrollar aún más rechazo hacia ideas contrarias, lo que nos hace aferrarnos con más fuerza a nuestras posturas. A esto se lo conoce como el "efecto boomerang", y representa un gran obstáculo cuando se intenta guiar a las personas hacia comportamientos más adecuados.

Por ejemplo, estudios han demostrado que los mensajes de información pública dirigidos a reducir el hábito de fumar, consumo de alcohol y de drogas habían tenido todos el efecto contrario.

Haz amigos

Si no puedes confiar en los hechos,entonces ¿cómo consigues que la gente descarte sus teorías conspirativas u otras ideas irracionales?

La alfabetización científica probablemente ayude a largo plazo. Con esto no me refiero a conocer hechos, cifras o técnicas específicas, sino más bien a entender el método científico y desarrollar pensamiento analítico. De hecho estudios muestran que descartar teorías conspirativas está asociado con un pensamiento más analítico. La mayoría de la gente nunca hará ciencia propiamente dicha, pero se encuentra y usa la ciencia a diario, por lo que los ciudadanos necesitan habilidades para evaluar críticamente afirmaciones científicas.

Por supuesto, modificar el currículo nacional no servirá para resolver mi discusión en el tren. Para un enfoque más inmediato, es clave darse cuenta de que pertenecer a un grupo o tribu ayuda mucho. Antes de empezar a difundir un mensaje, busca puntos en común.

Mientras tanto, para evitar el efecto contraproducente, ignora los mitos. No los menciones ni los reconozcas. Simplemente presenta los puntos clave: las vacunas son seguras y reducen entre un 50 % y un 60 % las probabilidades de contraer gripe, y ya está. No hables de los conceptos erróneos, porque suelen recordarse mejor que los hechos.

Además, no provoques una reacción defensiva en tus oponentes al cuestionar directamente su visión del mundo. En lugar de eso, ofrece explicaciones que sean compatibles con sus creencias previas. Por ejemplo, los conservadores que niegan el cambio climático estarán más dispuestos a cambiar de opinión si se les presentan opciones que incluyan beneficios empresariales y protección al medio ambiente.

Una sugerencia más: usa historias para explicar tu punto. La gente se involucra mucho más con narrativas que con diálogos argumentativos o descriptivos. Las historias conectan causa y efecto de manera natural, haciendo que las conclusiones que quieres transmitir parezcan casi inevitables.

Todo esto no quiere decir que los hechos y el consenso científico no sean importantes. Al contrario, son fundamentales. Pero entender las fallas en nuestro propio pensamiento nos permite comunicar nuestras ideas de forma mucho más efectiva y convincente.

Es fundamental cuestionar los dogmas, pero en lugar de unir puntos sin conexión para crear teorías conspirativas, debemos exigir evidencia a quienes toman decisiones. Pide ver los datos que respaldan una creencia y busca información que la respalde o la refute. Parte de este proceso es reconocer nuestros propios sesgos, limitaciones y errores de razonamiento.

Entonces, ¿cómo podría haber sido mi conversación en el tren si hubiera seguido mi propio consejo? Volvamos al momento en que noté que la charla empezaba a tomar un rumbo conspirativo. Esta vez, respiro hondo y digo:

—Oye, gran resultado en el partido. Lástima que no conseguí entradas.

Pronto estamos inmersos en una conversación mientras discutimos las chances del equipo esta temporada. Unos minutos después, me dirijo al teórico de la conspiración lunar:

—Oye, estaba pensando en lo que dijiste sobre los alunizajes. ¿No se veía el sol en algunas fotos?

Asiente.

—Entonces era de día en la Luna. Y al igual que acá en la Tierra, ¿esperarías ver estrellas en el cielo?

—Ajá, supongo que no, no lo había pensado. Quizá ese blog que consulté antes no tenía toda la razón.

No hay comentarios.:

Publicar un comentario